Пользовательский файл robots.txt для blogger

Файл robots.txt играет очень важную роль во взаимодействии сайта с поисковыми системами. В нем задается правило индексации вашего ресурса. А если допустить ошибку при написании robots.txt, то сайт может полностью вылететь из индекса или поисковики будут индексировать все подряд.

В Blogger родной файл robots.txt выглядит следующим образом:

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

По данному правилу поисковые роботы могут индексировать на сайте все, кроме страниц с директивой search: это архивы, страницы из карты сайта, которые создают дубли. А этого мало, поэтому нужно загрузить свой персональный файл robots.txt, где будет указаны все необходимые моменты.

Настройка пользовательского файл robots.txt

Чтобы загрузить пользовательский файл robots.txt в Blogger необходимо в настройках найти блок: "Поисковые роботы и индексирование".

Затем, напротив строки: "Использовать собственный файл robots.txt", сдвинуть ползунок вправо. После чего, кликнуть по строке: "Пользовательский файл robots.txt".

Во всплывающем окне пропишите следующий код и сохраните изменения:

User-agent: Mediapartners-Google

Disallow:

Disallow:

User-agent: *

Disallow: /search

Disallow: /p/search.html

Disallow: /*?showComment*

Disallow: /feeds/

Allow: /

Sitemap: https://news-sawich.blogspot.com/sitemap.xml

Disallow: /p/search.html

Disallow: /*?showComment*

Disallow: /feeds/

Allow: /

Sitemap: https://news-sawich.blogspot.com/sitemap.xml

User-agent: Yandex

Disallow: /search

Disallow: /p/search.html

Disallow: /feeds/

Disallow: /*?m=1

Disallow: /*?showComment*

Disallow: /?q=

Allow: /

Sitemap: https://news-sawich.blogspot.com/sitemap.xml

Disallow: /search

Disallow: /p/search.html

Disallow: /feeds/

Disallow: /*?m=1

Disallow: /*?showComment*

Disallow: /?q=

Allow: /

Sitemap: https://news-sawich.blogspot.com/sitemap.xml

В данном коде замените, выделенный красным, адрес Sitemap на свой.

Если вкратце, то в пользовательском файле мы указали больше вариантов того, что поисковики не должны индексировать на сайте, а также, задали правила индексации специально для яндекса. К тому же, указали ссылку на карту сайта.

Настройка персонализированных тегов robots для заголовков

После того, как был добавлен пользовательский файл robots.txt, необходимо настроить персонализированные теги robots для заголовков.

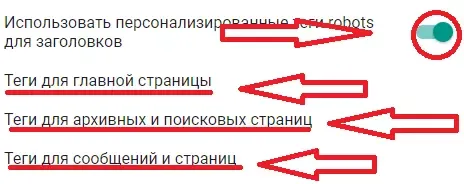

Для этого, в этом же блоке: "Поисковые роботы и индексирование", сдвигаете ползунок вправо напротив строки: "Использовать персонализированные теги robots для заголовков".

Затем, для настройки тегов, поочередно кликаете на каждую строку и вносите следующие изменения:

1. Для главной страницы должны быть активированы следующие теги: all и noodp.

2. Для архивных и поисковых страниц должны быть активированы теги: noindex, nofollow, noarchive и nosnippet.

3. Для сообщений и страниц должны быть активированы следующие теги: all и noodp.

Как посмотреть robots.txt любого сайта

Если вы решили посмотреть файл robots.txt какого-то сайта, то сделать это очень просто. Всего лишь нужно в поисковой строке ввести следующее: адрес_интересующего_сайта/robots.txt. То есть, к адресу интересующего сайта добавить: /robots.tx. И у вас откроется страница с интересующей вас информацией.

Если по какой-то причине страница не будет найдена, то это означает что доступ к файлу закрыт или отсутствует на сайте.

Комментарии